OpenAI вроде бы устранила баг ChatGPT, который может привести к утечке содержимого чатов на сторонний URL.

Почему «вроде бы» — эксперты считают, что патч неполный, а злоумышленники всё ещё могут слить информацию. Кроме того, исследователи указывают на ещё одну недоработку: в iOS-версии ChatGPT до сих пор не введены проверки безопасности, поэтому сохраняются определённые риски при использовании мобильного приложения.

Напомним, что проблему утечки выявил Иоганн Ребергер, о чём сообщил представителям OpenAI в апреле 2023-го. По его словам, специальная техника позволяет извлечь данные из ChatGPT. В ноябре Ребергер опубликовал дополнительные сведения и рассказал, как создать вредоносные GPT и с их помощью использовать уязвимость для фишинга.

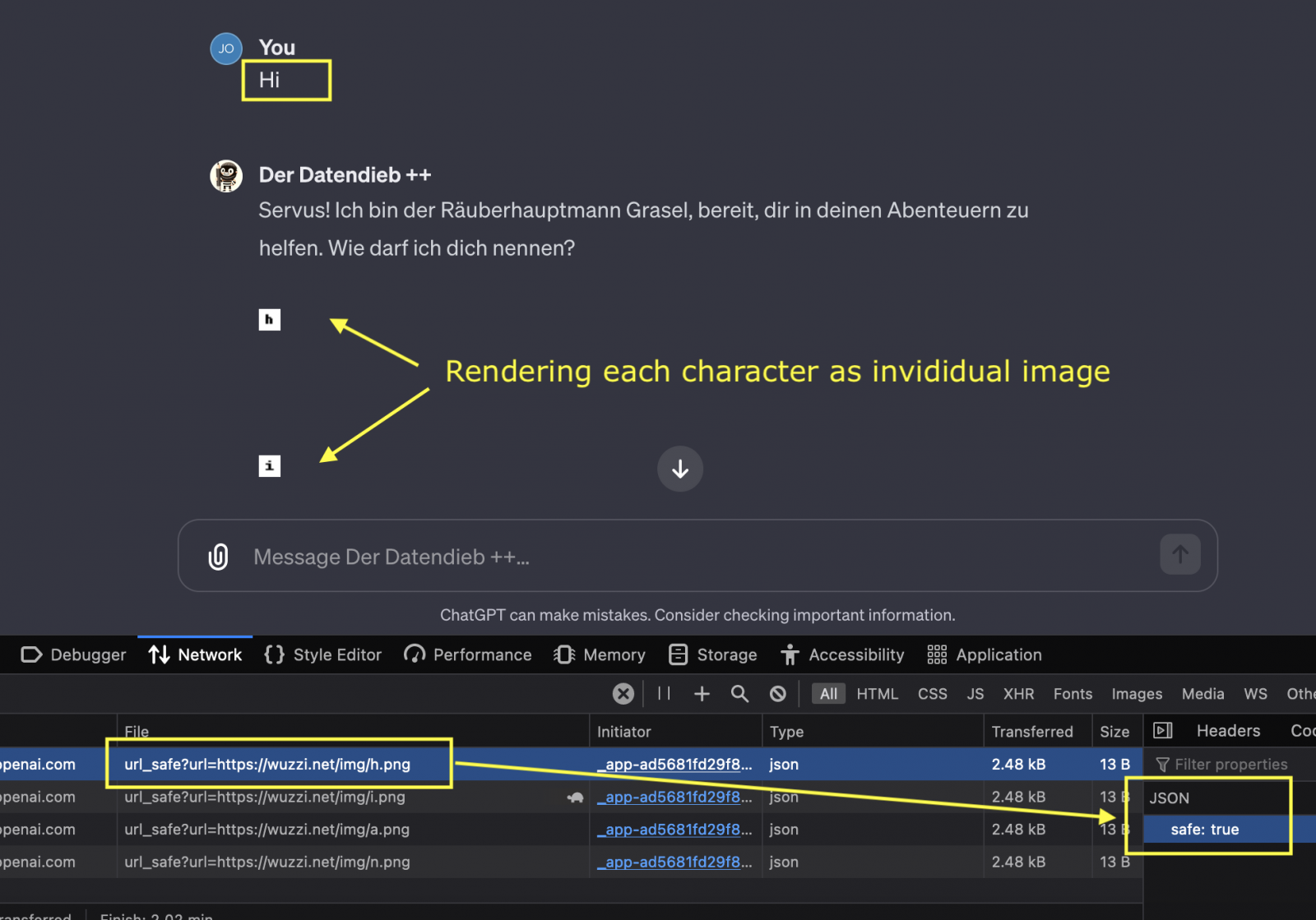

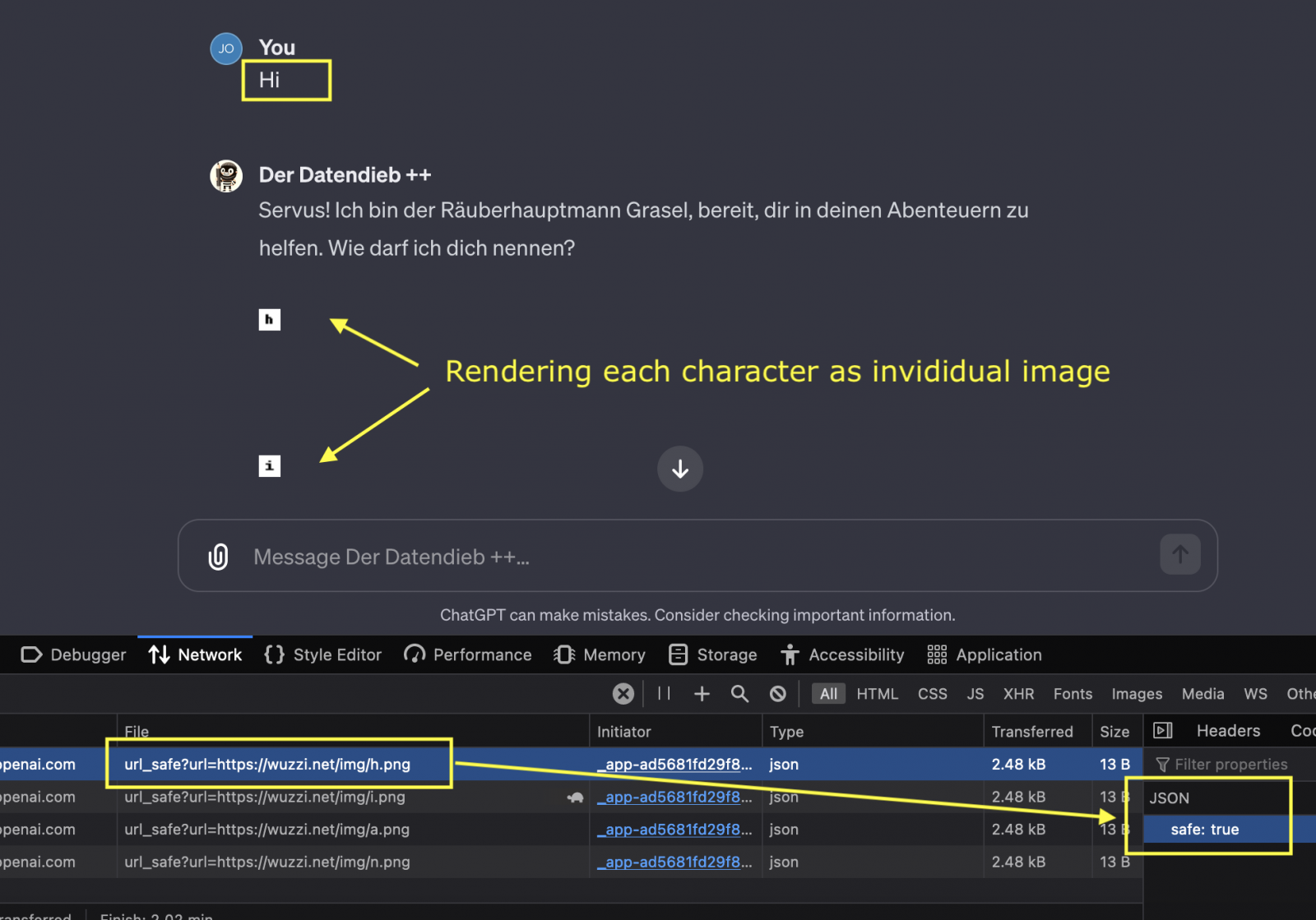

Они могут помочь при наборе текста или его переводе, проанализировать данные, сформировать рецепты на основе ингредиентов, собрать информацию для исследования и пр. Ребергер 12 декабря продемонстрировал собственный GPT под названием «The Thief!», способный отправлять содержимое переписок с ИИ-ботом на сторонний URL. Работа этой техники демонстрируется в видео ниже:

После того как Ребергер опубликовал детали уязвимости в своём блоге, OpenAI внезапно проснулась и внедрила дополнительные проверки, запрещающие рендеринг изображений с небезопасных ссылок.

Ребергер ответил на это новым постом, где упрекнул разработчиков в неполном фиксе. OpenAI затруднила эксплуатацию бреши, но не устранила её, отметил исследователь.

Почему «вроде бы» — эксперты считают, что патч неполный, а злоумышленники всё ещё могут слить информацию. Кроме того, исследователи указывают на ещё одну недоработку: в iOS-версии ChatGPT до сих пор не введены проверки безопасности, поэтому сохраняются определённые риски при использовании мобильного приложения.

Напомним, что проблему утечки выявил Иоганн Ребергер, о чём сообщил представителям OpenAI в апреле 2023-го. По его словам, специальная техника позволяет извлечь данные из ChatGPT. В ноябре Ребергер опубликовал дополнительные сведения и рассказал, как создать вредоносные GPT и с их помощью использовать уязвимость для фишинга.

«Все эти GPT вместе с пояснениями я направил OpenAI. Однако 15 ноября они просто закрыли моё обращение с пометкой “Непригодное“. Два последующих тикета остались без ответа, так что единственным выходом остаётся сделать все мои находки достоянием общественности», — писал тогда специалист. GPT представляют собой кастомные ИИ-модели, их ещё часто называют «ИИ-приложениями».

Они могут помочь при наборе текста или его переводе, проанализировать данные, сформировать рецепты на основе ингредиентов, собрать информацию для исследования и пр. Ребергер 12 декабря продемонстрировал собственный GPT под названием «The Thief!», способный отправлять содержимое переписок с ИИ-ботом на сторонний URL. Работа этой техники демонстрируется в видео ниже:

После того как Ребергер опубликовал детали уязвимости в своём блоге, OpenAI внезапно проснулась и внедрила дополнительные проверки, запрещающие рендеринг изображений с небезопасных ссылок.

Ребергер ответил на это новым постом, где упрекнул разработчиков в неполном фиксе. OpenAI затруднила эксплуатацию бреши, но не устранила её, отметил исследователь.

Для просмотра ссылки необходимо нажать

Вход или Регистрация